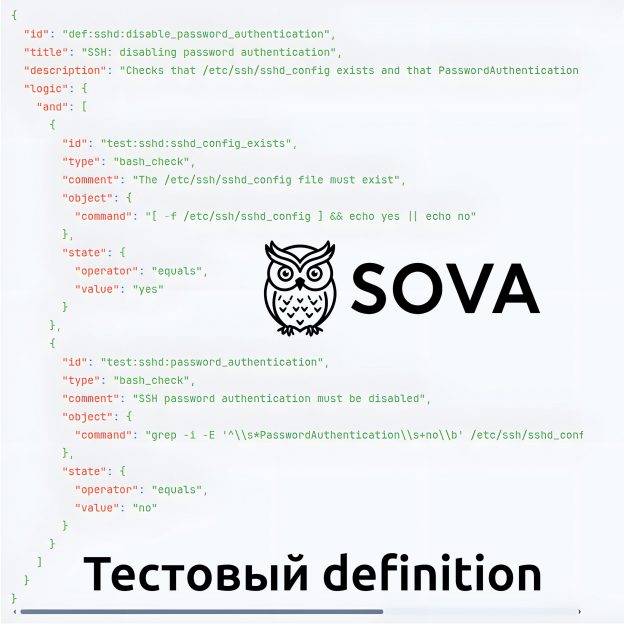

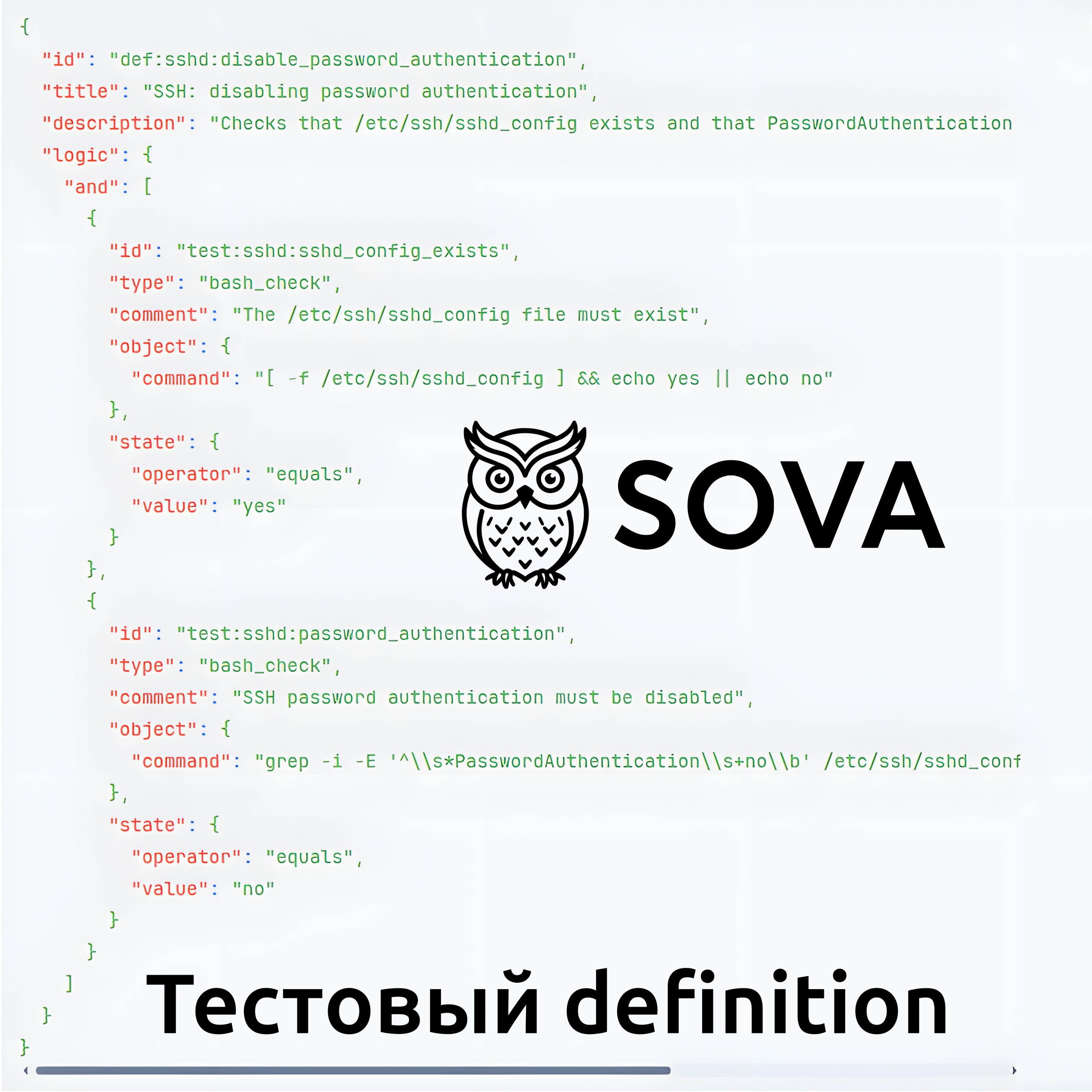

Сегодня покрутил идею SOVA - проекта упрощённого аналога OVAL, о котором я писал в октябре. В итоге набросал тестовый дефинишен, описывающий проверку отключения аутентификации по паролю на SSH-сервере.

Как можно видеть, здесь комбинация двух тестов, выполняющих bash-скрипты, статусы которых объединяются по И. Всё сразу наглядно читается и, как я подозреваю, такие дефинишены будет очень просто генерить нейронкой по тексту из руководств по харденингу а-ля CIS Benchmarks. 😉

Проект завёл на платформе GitVerse от Сбера. Буду потихоньку его вайб-кодить в свободное время. 🙂 GitVerse, кстати, вполне норм. На мой неискушённый взгляд, ничем GitHub-у не уступает, можно пользоваться. 😉