Прожектор по ИБ, выпуск №15 (09.12.2023): Нейролингвистические атаки на ИИ

🔸 Александр Леонов, "Управление уязвимостями и прочее"

🔸 Лев Палей, "Вести из Палей"

🔸 Максим Хараск, "Global Digital Space"

00:00 Здороваемся и смотрим статистику по прошлому эпизоду

01:56 Про конференцию Код ИБ Итоги 2023

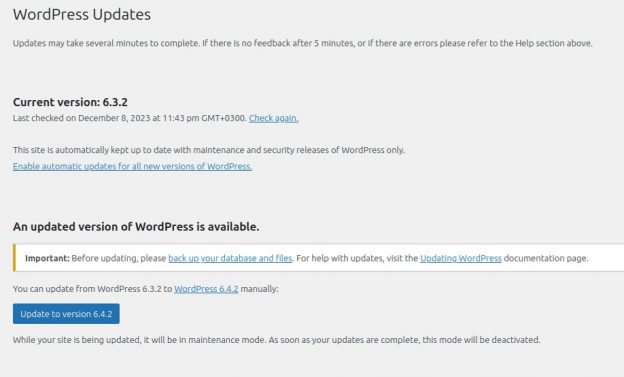

08:14 Фишинговая атака на админов WordPress и настоящая RCE

13:39 У NVD превратятся в тыкву фиды и API 1.0, что делать?

17:36 Нейролингвистические атаки на ИИ и автоматическая конвертация BASH в Python

26:00 Стратегия развития области связи

34:17 Премия Киберпросвет

38:59 Прощание от Mr.X