Прожектор по ИБ, выпуск №23 (18.02.2024): Прощальный рэп

🔸 Александр Леонов, "Управление уязвимостями и прочее"

🔸 Лев Палей, "Вести из Палей"

00:00 Здороваемся, смотрим статистику, Лев рассказывает почему больше не будет участвовать в Прожекторе по ИБ 😔

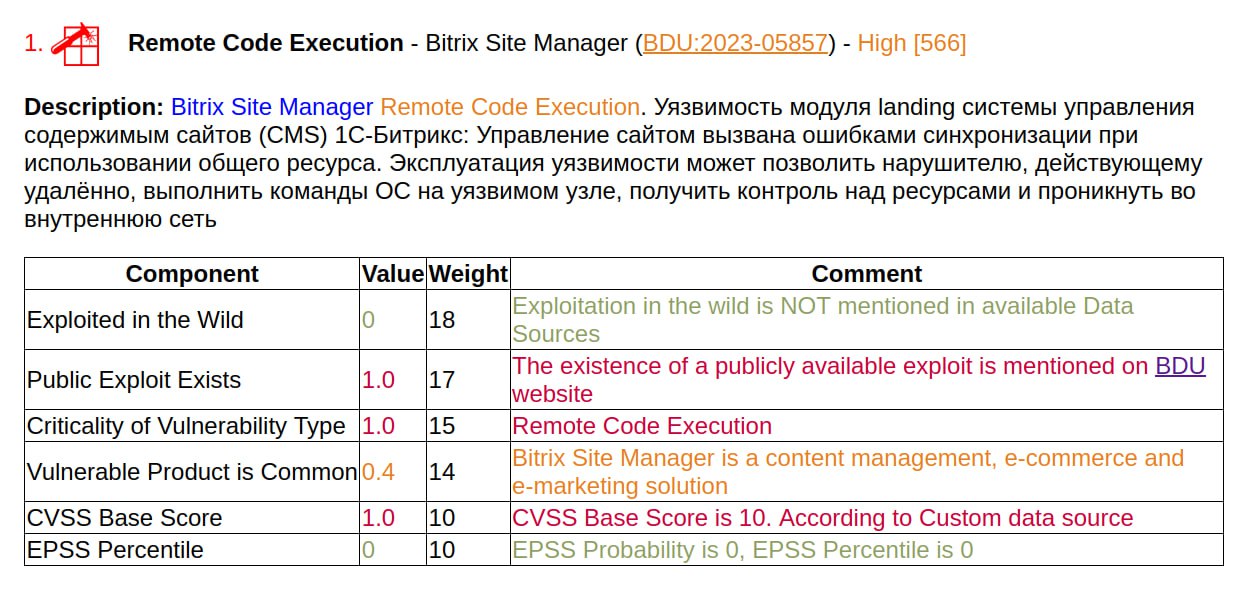

02:23 Дайджест трендовых уязвимостей за январь 2024 от Positive Technologies

05:22 Новый бэкдор для Ivanti Connect Secure и анализ апплаенса Ivanti

10:42 Февральский Microsoft Patch Tuesday, ошибочный временный взлёт RCE Outlook и взлёт уязвимости Exchange

15:17 Фишинговые рассылки на тему выплат за детей от 3 до 16 лет

18:24 Cтатистика по мошенничествам на сервисах знакомств в День святого Валентина

20:40 0day уязвимость EventLogCrasher в Windows

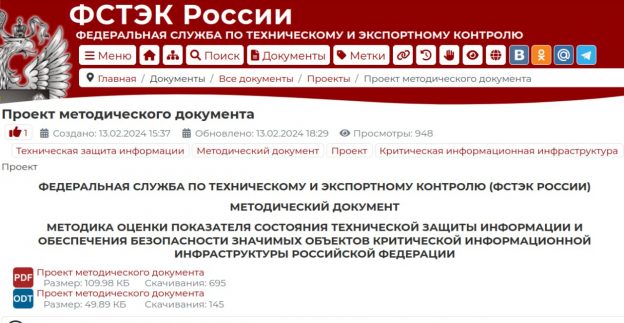

25:50 Драфт "Методики оценки показателя состояния технической защиты информации и обеспечения безопасности значимых объектов критической информационной инфраструктуры Российской Федерации" в контексте Управления Уязвимостями

34:35 Обсуждение руководства по управлению уязвимостями от британских регуляторов

38:37 🎤 Лев зачитывает прощальный рэп, вспоминаем/осуждаем Peiter Zatko (бывший CISO Twitter)